Creación automática de mundos 3D y texturas mediante algoritmos generativos y redes neuronales

En los últimos años, las estrategias y formas de abordar la creación de mundos en 3D han sufrido una transformación radical. Así como sus correspondientes tecnologías adicionales como lo son las texturas, la iluminación, el modelamiento de formas, etc.

Antes, este proceso significaba un extenso trabajo y exhaustivo por parte de modeladores, diseñadores y artistas. Aunque se apoyaban con herramientas de esculpido digital la carga aún era muy alta. Ahora es capaz de lograrse de manera más automatizada gracias a esta inmersión y convergencia de algoritmos generativos y redes neuronales. Cabe resaltar que esta transición ha sido posible gracias a 3 factores importantes. Primero, el crecimiento exponencial de la visión por computadora gracias a la evolución de la inteligencia artificial en este campo. Segundo, el incremento de la capacidad computacional (principalmente gracias a GPUs y TPUs). Y tercero, la evolución de las técnicas para manejar grandes volúmenes de datos tridimensionales de una manera más eficiente. (Chen K., Ramsey L., 2024).

El impacto de esta evolución en la tecnología se extiende a múltiples sectores. En la industria de los videojuegos, permite generar entornos complejos en cuestión de segundos, adaptados dinámicamente a las acciones del jugador. Otro ejemplo se encuentra en la arquitectura y urbanismo, donde posibilita prototipar entornos completos para simular iluminación, circulación de personas y distribución de espacios. En la producción cinematográfica, reduce drásticamente los tiempos de modelado y texturizado, permitiendo a los equipos artísticos centrarse en la narrativa visual. Incluso en áreas como la robótica o la simulación científica, la generación procedimental de mundos 3D facilita la creación de escenarios realistas. Escenarios usados para entrenamiento de agentes autónomos sin necesidad de capturar datos reales.

Representaciones y arquitecturas para la creación de mundos 3D

Como se mencionó anteriormente, esta evolución tecnológica ha redefinido los procesos de creación. Sobre todo, las estructuras fundamentales sobre las que se construyen los entornos tridimensionales. Es por esto, que para comprender cómo se generan estos mundos de manera eficiente y realista, es clave analizar la base. Todo sistema de creación de mundos 3D es la representación elegida para describir la geometría y arquitectura computacional. Entre las más comunes encontramos:

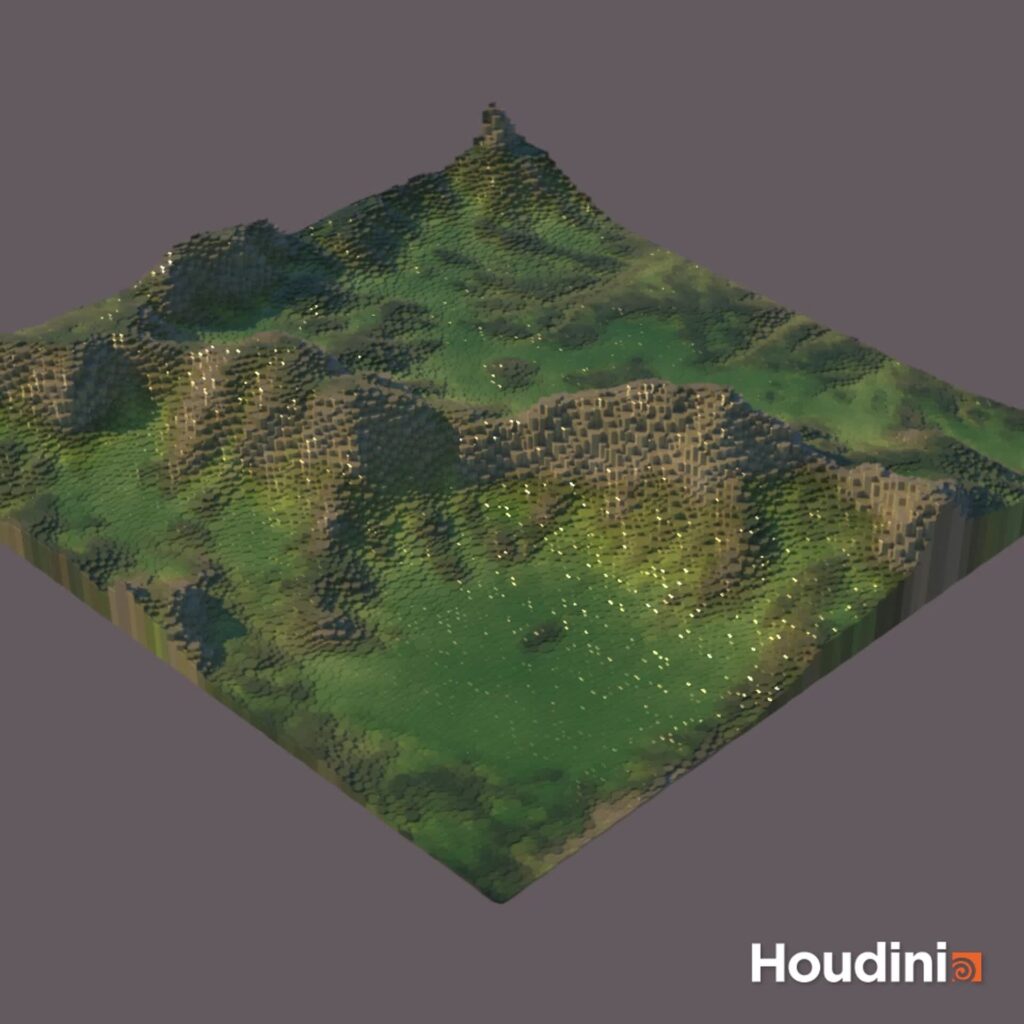

- Voxel grids: Estructuras tridimensionales equivalentes a píxeles en 2D, donde cada celda (voxel) contiene información sobre ocupación y, en ocasiones, color o material. Son fáciles de manejar con redes convolucionales 3D. Sin embargo, su consumo de memoria crece de manera cúbica con la resolución, lo que limita su uso a modelos de baja a media complejidad. (Chen K., Ramsey L., 2024).

- Nubes de puntos: Conjuntos dispersos de coordenadas que representan la superficie de los objetos. Su principal ventaja es la eficiencia y la precisión para capturar formas. Aunque requieren métodos especializados como PointNet o Graph Neural Networks para ser procesadas adecuadamente.

- Mallas poligonales: Conformadas por vértices, aristas y caras, constituyen el estándar en la industria. Permiten un control detallado sobre la superficie y se integran directamente en motores gráficos como Unity o Unreal Engine. Sin embargo, manipular su topología de forma directa es más complejo que trabajar con voxeles.

- Representaciones implícitas: Modelos matemáticos continuos, como los campos de distancia firmada (SDF) o las funciones de radiancia neuronal (NeRFs). Estos modelos codifican la geometría como una función evaluable en cualquier punto del espacio. Ofrecen detalle infinito y transiciones suaves, aunque conllevan un mayor coste computacional durante la renderización.

Principales modelos generativos

Una vez comprendidas algunas de las representaciones y arquitecturas que permiten describir la geometría tridimensional, el siguiente paso es analizar aquellas técnicas de creación automática. Técnicas conocidas como los modelos generativos. Siendo así, que su desarrollo ha revolucionado la forma en que se da la creación de los mundos 3D. No solo definen cómo se representa el mundo, sino también cómo se sintetiza, se transforma y se adapta. Todo esto se logra mediante algoritmos de aprendizaje profundo. Algunos ejemplos incluyen:

- Variational Autoencoders (VAEs): Permiten codificar y decodificar formas tridimensionales, generando nuevas instancias al muestrear en un espacio latente continuo. Son muy útiles para interpolar entre objetos o generar variaciones controladas.

- Redes Generativas Antagónicas (GANs): Son un tipo de inteligencia artificial. Funcionan a partir de 2 modelos, uno que crea imágenes (conocido como el generador) y otro que evalúa estas imágenes (el discriminador). Estos 2 modelos están constantemente en una especie de competencia. Donde básicamente el objetivo es que el generador “aprenda” a producir imágenes tan realistas que el discriminador no sepa distinguir si son verdaderas o falsas. Esta técnica ha permitido demostrar ser muy efectiva a la hora de lograr crear elementos visuales sorprendentes.

- Modelos de difusión: Han venido en auge desde 2021, por la capacidad que tienen para generar contenido a partir de ruido aleatorio. Este ruido es refinado progresivamente, esto hasta que logre generar una representación coherente. Al realizar una comparación con las GAN`s, estos modelos ofrecen mayor estabilidad lo que los hace menos propensos a colapsos de modo. En el ámbito 3D, los modelos de difusión se aplican tanto a la geometría como a texturas. Por ejemplo, ImmerseGen utiliza difusión latente para generar texturas RGBA coherentes. Estas texturas pueden incluso estar condicionadas por descripciones textuales, lo que demuestra su flexibilidad multimodal y su potencial para lograr resultados visuales detallados y consistentes

- Modelos guiados por CLIP: Relacionan descripciones textuales con imágenes o geometrías, lo que permite crear mundos completos a partir de simples frases en lenguaje natural.

- Enfoques autorregresivos y normalizing flows: Aunque menos populares en gráficos 3D, ofrecen control sobre la secuencia de generación y un modelado estadístico más preciso.

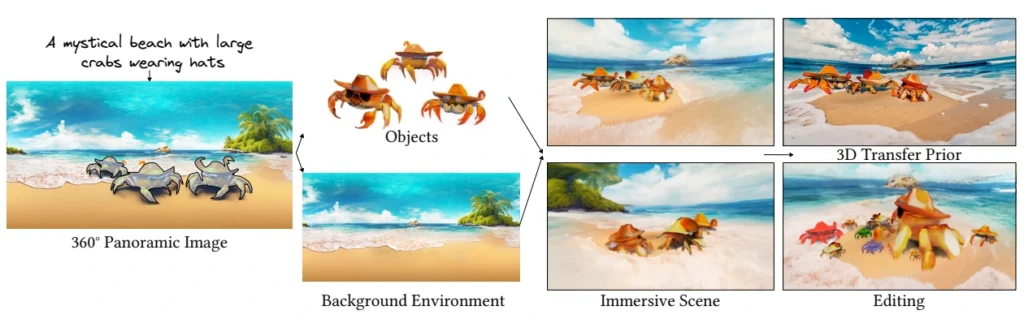

- DreamAnywhere: generación panorámica centrada en objetos. El proyecto DreamAnywhere propone e introduce una propuesta innovadora: Generar escenas panorámicas en 3D a partir de una sola imagen. Sin embargo, este proyecto le da un enfoque centralizado únicamente en la creación de objetos. (Liu J., Chen Y., et al., 2025).

Su pipeline tiene varias etapas clave. Primero para lograr aislar los objetos principales de la imagen, usa técnicas de segmentación y detección. La segunda etapa se centra en aplicar un modelado 3D implícito para cada uno de los objetos obtenidos de la etapa anterior. Finalmente realiza un ensamblaje de forma coherente para generar un entorno panorámico totalmente navegable. Este proceso puede observarse en la figura 3.

Esta técnica permite generar mundos o entornos tridimensionales a partir de datos mínimos. Además, abre también las posibilidades y el acceso a aplicaciones interactivas capaces de generar mundos 3D listos para explorar. Escenarios generados únicamente con una imagen de referencia introducida por el usuario.

Un aspecto importante y fundamental a la hora de querer abarcar el contexto de la generación de entornos tridimensionales es la elección del modelo. Esta elección depende del tipo de contenido que se desea generar, los requisitos de calidad y la capacidad de cómputo disponible. Por ejemplo, en entornos de realidad virtual o aumentada, donde el rendimiento en tiempo real es crucial. Para estos casos, a menudo se combinan representaciones ligeras con modelos optimizados para lograr una ejecución rápida y eficiente a la vez.

Optimización mediante algoritmos evolutivos

Aunque los modelos generativos ofrecen una base poderosa para la creación de mundos 3D, lograr resultados óptimos requiere ajustar múltiples parámetros y criterios.

Tal como plantea Molina Cuello (2020), la computación evolutiva ofrece un enfoque eficaz y versátil para optimizar la generación de mundos 3D. Este enfoque es útil cuando las funciones objetivo no son diferenciables (como medir la jugabilidad, la estética de un entorno o equilibrar múltiples criterios simultáneamente). En este contexto, los algoritmos genéticos destacan por su simplicidad y potencia. Estos algoritmos trabajan con poblaciones de posibles soluciones representadas como cromosomas. Y generación tras generación, aplican procesos inspirados en la evolución natural, como selección, cruce y mutación, para mejorar el rendimiento. Este enfoque permite refinar parámetros de manera iterativa, incluso en escenarios complejos donde los gradientes tradicionales no pueden aplicarse directamente

En un contexto de generación de mundos 3D, estos algoritmos pueden optimizar:

- La distribución espacial de elementos para maximizar jugabilidad o realismo.

- La disposición de texturas y materiales para mejorar la coherencia estética.

- El equilibrio entre densidad de objetos y rendimiento en tiempo real.

En Unity, Molina Cuello (2020) aplicó este enfoque para entrenar redes neuronales artificiales que controlaban agentes virtuales, utilizando un ciclo iterativo de evaluación y selección.

Texturizado y ensamblado de escenarios

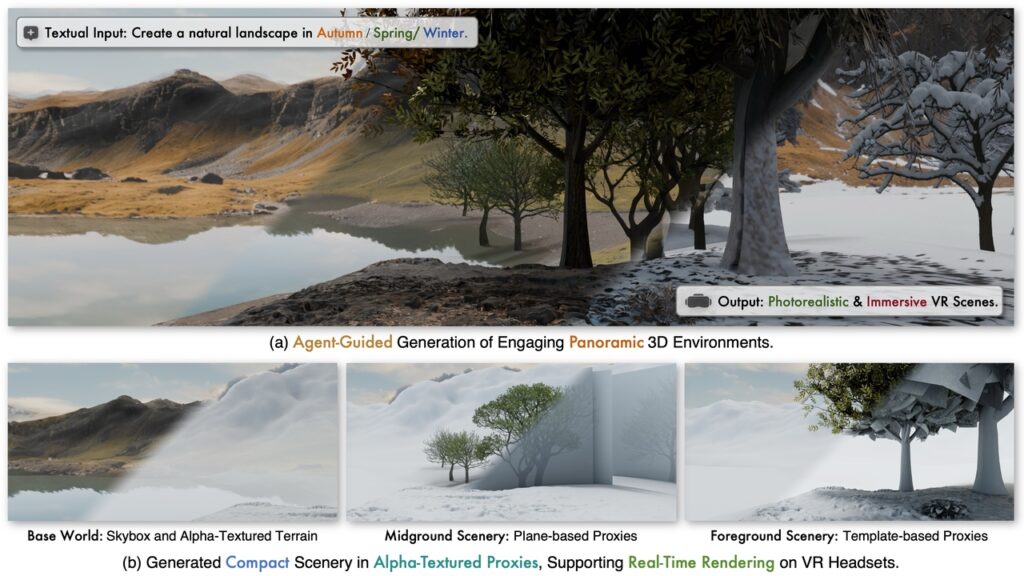

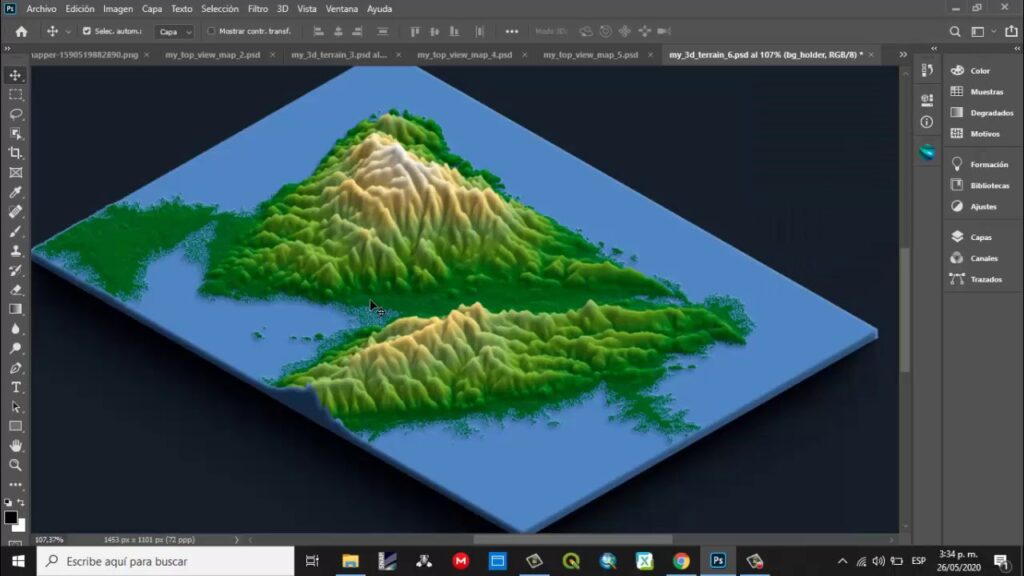

Aplicar y generar la geometría de los entornos automáticamente no es suficiente para lograr mundos tridimensionales realistas; aquí es donde entra el texturizado, este juega un papel crucial. Tradicionalmente, este proceso implicaba procesos complejos y extendiosos, lo que lo hacía costoso y difícil de escalar. Proyectos como ImmerseGen han propuesto una alternativa más eficiente: utilizar proxies geométricos ligeros y aplicarles texturas RGBA de alta resolución generadas mediante modelos de difusión condicionados (Yuan J., Yang B., Wang K., et al., 2025). Este enfoque permite mantener detalles sin sobrecargar la geometría. Además, el ensamblaje de escenas en ImmerseGen sigue un enfoque jerárquico que prioriza la eficiencia:

- Terreno base: Un plano o malla simplificada, texturizado con mapas de altura y color derivados de la topografía.

- Fondo y media distancia: Elementos de gran tamaño como montañas o edificaciones distantes, representados mediante planos texturizados o billboards que siempre miran al usuario.

- Primer plano interactivo: Objetos cercanos generados con bajo número de polígonos pero texturas de alta resolución, que soportan interacción y animación.

Este enfoque reduce el coste de renderizado sin sacrificar la percepción de realismo, un factor crítico para dispositivos VR autónomos con hardware limitado.

En contraste, DreamAnywhere genera escenas panorámicas centradas en objetos, modelando cada elemento detectado en la imagen de entrada y ensamblándolo en un entorno coherente.

Ambos enfoques reducen la necesidad de escaneos masivos y permiten crear mundos virtuales navegables a partir de una sola imagen, abriendo nuevas posibilidades para la generación 3D eficiente e interactiva

Integración de agentes y control multimodal

La automatización de mundos no se limita a generar geometría y texturas. ImmerseGen incorpora agentes inteligentes basados en modelos visual-lingüísticos capaces de interpretar descripciones textuales como “un bosque nevado con una cabaña de madera” y convertirlas en instrucciones precisas para la selección de activos, generación de texturas y posicionamiento (Yuan J., Yang B., Wang K., et al., 2025).

Estos agentes realizan un análisis semántico espacial utilizando una rejilla de ocupación, asegurando que los objetos generados no se solapen de forma incoherente y manteniendo relaciones lógicas entre ellos. Además, el sistema integra elementos dinámicos como meteorología, fauna y sonido ambiente, creando experiencias inmersivas no solo visuales, sino multisensoriales.

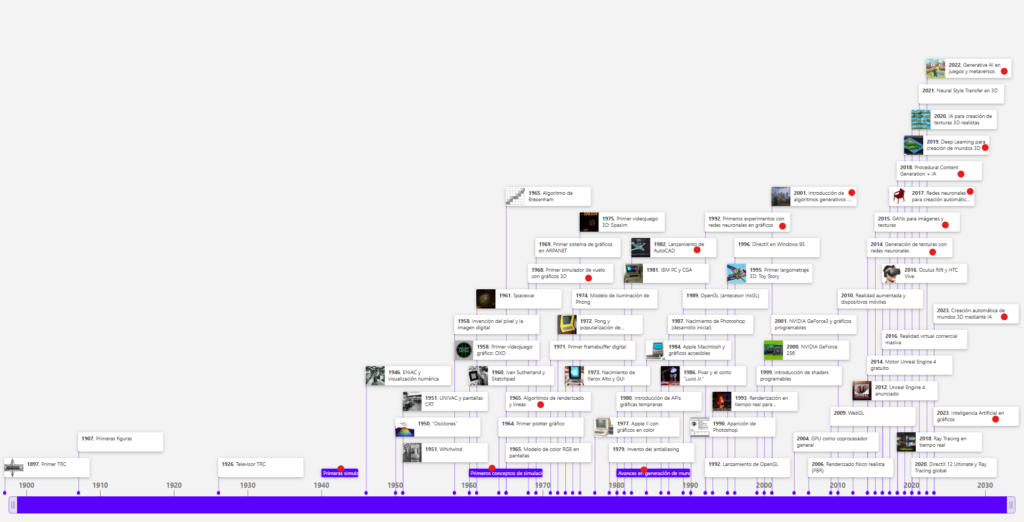

Creación de mundos 3D dentro de la historia de la computación gráfica

El tema de investigación “Creación automática de mundos 3D y texturas mediante algoritmos generativos y redes neuronales” no puede atribuirse a una única fecha de surgimiento, ya que es el resultado de múltiples avances acumulados dentro de la computación gráfica y la inteligencia artificial.

En la línea de tiempo general, se identificaron los siguientes hitos clave que dieron origen a este campo:

Retos actuales y perspectivas futuras para la creación de mundos 3D

A pesar de los avances, la generación automática de mundos 3D enfrenta retos significativos. Entre ellos:

- Los conjuntos de datos 3D de alta calidad son escasos, lo que restringe el entrenamiento de modelos robustos (Chen K., Ramsey L., 2024).

- Equilibrio entre calidad y rendimiento, Especialmente en entornos de ejecución en tiempo real, es necesario optimizar continuamente.

- Garantizar que un objeto generado sea consistente desde todos los ángulos sigue siendo un desafío técnico.

- La capacidad de modificar el mundo sobre la marcha o en tiempo real, en respuesta a las acciones del usuario, requiere modelos rápidos y adaptativos.

Créditos

Autor: Juan Pablo Montes León

Editor: Mg. Carlos Iván Pinzón Romero

Código: CG – 20252

Universidad: Universidad Central

Chen, K., & Ramsey, L. (2024). Deep Generative Models for 3D Content Creation: A Comprehensive Survey of Architectures, Challenges, and Emerging Trends. Preprints.org. https://doi.org/10.20944/preprints202410.2397.v1 El Geógrafo. (2021). Arcgis + DEM (Modelo Digital de Terreno) + Photoshop / Modelo 3D [Imagen]. YouTube. https://www.youtube.com/watch?v=pP4ivT1cJ6c Molina Cuello, Alberto (2020). Aprendizaje automático con algoritmos genéticos y redes neuronales., E.T.S.I. y Sistemas de Telecomunicación (UPM), https://oa.upm.es/68694/ La Fàbrica 3D. (2025). El Diseño Generativo Te Va a Volar la Cabeza | Así diseña la IA 🤯 [Video]. YouTube. https://www.youtube.com/watch?v=70WMPbqVBdI Liu, J., Chen, Y., et al. (2025). DreamAnywhere: Object-Centric Panoramic 3D Scene Generation. ArXiv, https://doi.org/10.48550/arXiv.2506.20367 Shiva Sai. (2024). Procedural 3D Morph [Imagen]. ArtStation. https://www.artstation.com/artwork/EvrrK0 Pixabay. (s,f). ai-generated-7813243_1280.jpg [Imagen]. Pixabay. https://pixabay.com/es/illustrations/ai-generado-planeta-paisaje-espacio-7813243/ Yuan, J., Yang, B., Wang, K., et al. (2025). ImmerseGen: Agent-Guided Immersive World Generation with Alpha-Textured Proxies. ResearchGate & arXiv. http://dx.doi.org/10.48550/arXiv.2506.14315