Hipótesis de la información

Que es la hipótesis de la información

La hipótesis de la información por Claude Shannon y Warren Weaver es planteada en 1948 surgió a base de la necesidad y la urgencia con que se necesitaba corregir errores comunes como por ejemplo y el principal de ellos es que anteriormente se usaban receptores a muy corta distancia y miles de cables para no perder la señal aparte de esto eran muy sensibles a elementos que generaban interferencia a raíz de este inconveniente Claude Shannon y Warren Weaver nos plantean lo siguiente.

ixoman00,2022.Historia.de.la.teoría.de.sistemas.[composición].Timetoast.comhttps://www.timetoast.com/timelines/historia-de-la-teoria-de-sistemas-57850f49-3fe7-4af3-a199-840d433323d3

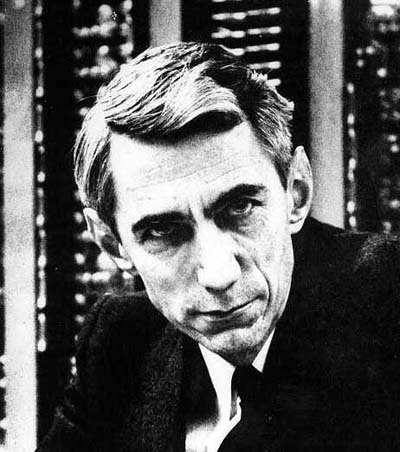

Claude Shannon Matemático, ingeniero eléctrico y criptógrafo durante la segunda guerra mundial se destaco en la defensa de los EE.UU, después de esto en 1948 publico un artículo y su teoría da lugar a lo que el asegura y nos plantea que si descubrimos un buen emisor y receptor del mensaje, este llegaría a mayor distancia siempre y cuando no prevalezca el canal por el que se desplaza.

En ese entonces el biólogo he informatologo Warren Weaver trabajaba como técnico de comunicaciones militar en el año que se publico el artículo, a lo que este se intereso y empezaron a trabajar juntos tanto así que publicaron un libró llamado la teoría matemática de la información y se refleja un modelo practico y lineal.

Son considerados gracias a esto los pioneros de la teoría de la información en donde se resalta el siguiente esquema:

Aclaración de la hipótesis de la información.

- Todo empieza en la fuente del mensaje, es la que genera el mensaje comunicado.

- La fuente es responsable de seleccionar el transmisor para codificar y convertir el mensaje para permitir que la señal viaje a través del canal.

- El canal es el medio físico por el cual viaja el mensaje y donde impide directamente el ruido.

- El ruido puede alterar el mensaje sumándose interferencias y otros tipos de problemas los cuales hacen que se pierda información.

- Entonces el mensaje llega a el receptor el cual se encarga de decodificar y transformar en lenguaje comprensible para el destino.

Así es como después de tantas irregularidades, el mensaje llega a el destino y cumple con su misión.

Aplicaciones de la Hipótesis de la Información

Según la información anterior (imagen 2) afirmamos que los mensajes que transmiten los medios de comunicación como lo es el radio, telégrafo, radio, periódico televisión entre otras como las señales eléctricas como los aparatos electrónicos como lo es el computador, sistemas servimecanicos entre otros para el proceso de datos.

Pero también los podemos encontrar en las señales que aparecen en los sistemas de todos los organismos vivos como por ejemplo las neuronas del cerebro donde es constante la información de un punto a otro y así poder generar una acción y no solo eso en general recibimos información por medio de los sentidos como el sonidos a través de la audición, imágenes y texto a través de la visión, olores a través del olfato y el tacto a través de los nervios de la piel.

Es decir que estamos todo el tiempo en constante comunicaciòn en nuestras vidas cotidianas ya sea obteniendo información de otros organismos vivos, en medios de comunicaciòn masiva, en bases de datos dentro del sistema y en toda clase de fenómenos que tenemos en nuestro medio ambiente .

Infoamerica.(s/f).Claude Elwood Shannon (1916-2001).[imagen].infoamerica. http://3.bp.blogspot.com/-HEfvt6T-sJw/T066YVF8FFI/AAAAAAAAABg/h9I1Xwu61yk/w1200-h630-pk-no-nu/claude_shannon+foto.jpg

¿Una mente brillante?

Una mente resplandeciente, la cual nos da conceptos actuales como los circuitos integrales o la inteligencia artificial. Desde joven demostró su interés por circuitos eléctricos y tecnológicos, en su adolescencia nos planteo proyectos importante en ese entonces como un barco tele dirigido y un telégrafo.

Luego de estudiar matemáticas e ingeniería desarrollo las bases de sus investigaciones en MIT Massachusetts donde trabajo en el que es considerado el primer ordenador de la historia propulsor de Internet que hoy en día es la mayor fuente de información del siglo XXI.

Es considerado el padre y pionero principal de la hipótesis de la información presentada en 1948 lo que es de gran importancia para el desarrollo de los sistemas de la comunicación de la actualidad.

No menos importante es el primero utilizando el término ´bit´ como la unidad mas pequeña de la información, por ende se le atribuye a su invención en 1948 en Bell Laboratorios a los 33 años de edad.

Gracias a sus aportes en 1938 en su tesis doctoral en el MIT, nos enseña como usar el álgebra de boole en la electrónica, para el análisis de síntesis de la conmutación de los circuitos digitales a lo que da origen de las computadoras como hoy las conocemos.

Invención en medio de la guerra

Cabe destacar que durante la segunda guerra mundial en 1941 hasta 1956, Claude Shannon trabajó para el Departamento de Defensa de EE. UU donde logro desarrollar el control de fuego y detección de enemigos mientras hacían defensa aérea. Estableció una relación gubernamental entre el presidente en ese entonces de los EE UU y el primer ministro del Reino Unido.

De igual manera se interesó por la idea de la crepitación del habla de Turing en 1943 ya había publicado un trabajo sobre pro-mediación y predicción de datos en sistemas de control de incendios en 1945. Es coautor de Ralph B. Blackman y H. Bode. Simula un sistema especial que procesa información y señales especiales, marcando el comienzo de la era de la información.

Una vida de sabiduría.

Cabe destacar su investigación científica en el campo de las matemáticas financieras donde encontramos por ejemplo el circuito eléctrico del flujo de dinero en EE UU, estudios en la justificación para elegir una cartera de inversiones y un aporte en los fondos de pensiones y en la asignación de activos monetarios.

El científico fue el primero en aplicar el método científico al concepto de información y las leyes de la criptografía, y sus ideas se basaban tanto en la teoría de la comunicación en sistemas secretos como en la teoría de la comunicación matemática; ademas de esto Recibió un Premio Nacional de Investigación en 1942 por su trabajo en la organización de circuitos de conmutación de dos polos.

El ´Memorandum´ secreto de Shannon que habla de la teoría matemática en el campo de la criptografía en el 1945 demostró que la criptografía y la teoría de la comunicación son inseparables.

Claude Shannon publicó su colección de artículos en 1993, que incluía 127 de sus trabajos científicos y gracias a sus inventos que sirvieron para transformar a el mundo es una de las figuras más importantes del siglo XX.

Claude Elwood Shannon matemático, ingeniero eléctrico y criptógrafo estadounidense, conocido como el “padre de la teoría de la información“. Pasó sus últimos años en la pensión de Massachusetts debido a la enfermedad de Alzheimer (30 de abril de 1916 – 24 de febrero de 2001)

Referencias

1.Baguetto IRL.19 dic 2017.TEORÍA.DE.LA.INFORMACIÓN.📻.|.Shannon.y.Weaver.Youtube.https://www.youtube.com/watch?v=qAbegfjieV

2.Severtra(2021).(s/f).Claude.Shannon.es.el.fundador.de.la.teoría.de.la.información.Quién.es.Claude.Shannon.y.por.qué.es.famoso.Teoría de la comunicación en sistemas secretos.https://severnyetravy.ru/es/klod-shennon-osnovatel-teorii-informacii-kto-takoi-klod-shennon-i-chem-on/

3.(s/f).encolombia.2014. La Teoría de la Comunicación y la Teoría de la Información. Encolombia.com. https://encolombia.com/medicina/revistas-medicas/academedicina/va-44/elcomputadorcibernetica1/

Autor: Uderney Bustos Gaviria.

Editor: Carlos Iván Pinzón Romero

Código: UCPS-1

Universidad: Universidad Central