Animación facial con Machine Learning

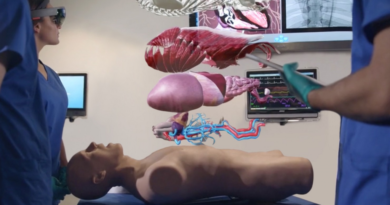

Cuando alguien menciona “animación facial”, la imagen que me viene a la cabeza es la típica escena de making of: un actor en medio de un set iluminado como quirófano, con decenas de puntitos pegados en la cara, rodeado de cámaras que parecen no dejar escapar ni un parpadeo. Tal vez sea porque durante años esa fue la única manera de capturar cada gesto con precisión quirúrgica.

Pero las cosas han cambiado, y bastante. Hoy, en lugar de un ejército de técnicos y un presupuesto de película de Hollywood, existen métodos mucho más accesibles que logran resultados igual de sorprendentes. El secreto está en el avance del machine learning y en algoritmos que, sinceramente, parecen sacados de ciencia ficción, pero que ya se usan todos los días sin que nos demos cuenta.

En las siguientes líneas quiero contarte, sin demasiada jerga técnica, cuáles son cinco de las técnicas que más están marcando tendencia en el mundo de la animación facial. No voy a limitarme a enumerarlas: también te compartiré ejemplos, comparaciones con métodos antiguos y, de paso, algún que otro comentario personal sobre por qué creo que estas tecnologías están marcando un antes y un después.

Captura facial con redes neuronales profundas

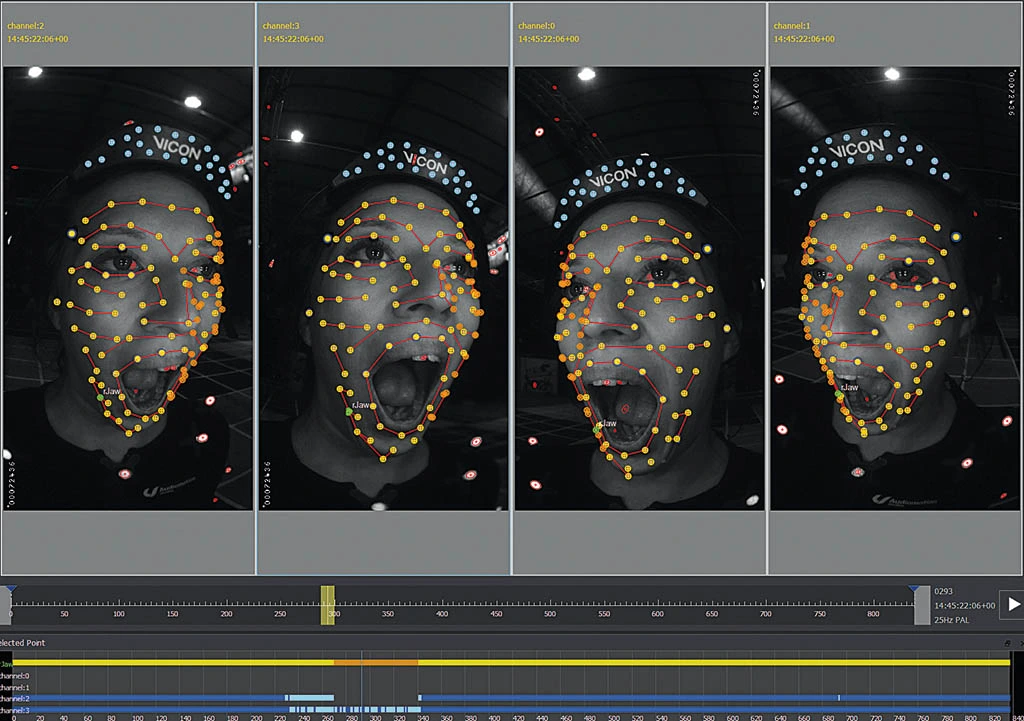

Hace apenas unos años, reproducir una interpretación facial convincente era una tarea épica. Piensa en una sala repleta de cámaras de alta velocidad, luces estratégicamente ubicadas y, para rematar, decenas de pequeños marcadores pegados en el rostro de un actor.

Cada parpadeo, cada leve arqueo de ceja, quedaba registrado en un mar de datos que luego se procesaban durante semanas. Esto lo vimos en producciones como Avatar o El Señor de los Anillos con Gollum, donde Andy Serkis se convirtió en leyenda del motion capture.

El problema era que este proceso, aunque espectacular, estaba al alcance de muy pocos. Requería no solo infraestructura costosa, sino también un equipo técnico con mucha experiencia. Ahí es donde entran las redes neuronales profundas.

Hoy, con una simple cámara (incluso la de un teléfono), un buen modelo de machine learning puede reconocer y reproducir con fidelidad los gestos de una persona, sin necesidad de marcadores ni configuraciones extremas.

Este cambio ha democratizado la animación facial. No es exagerado decir que cualquier creador independiente con un ordenador decente puede, en cuestión de horas, obtener resultados que antes costaban millones. Además, el flujo de trabajo se ha vuelto mucho más ágil: en lugar de días enteros de limpieza de datos, los algoritmos procesan y generan la animación casi en tiempo real.

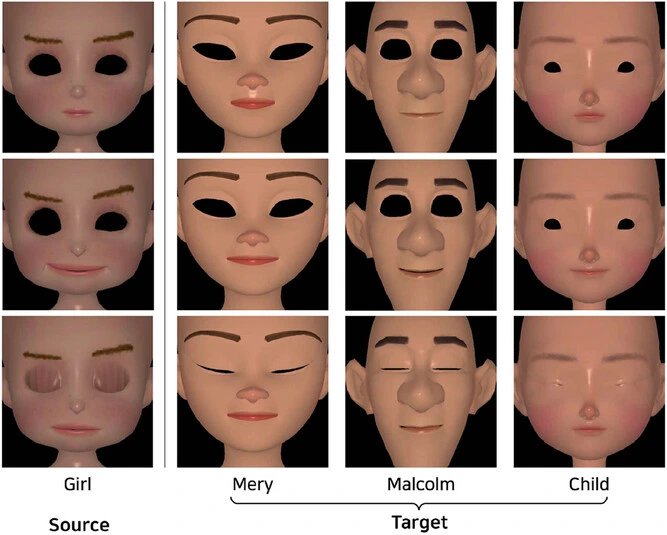

Transferencia de animación facial

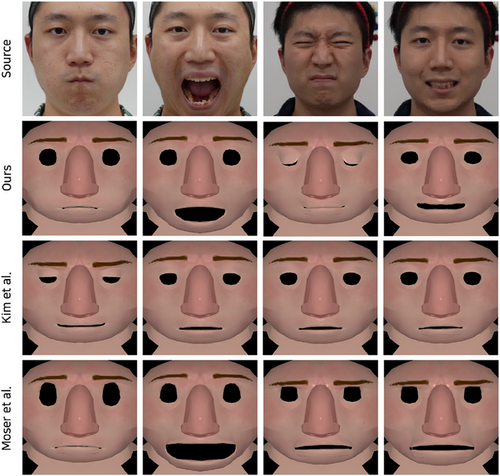

Piensa por un momento en esta escena: grabas a un actor durante un momento de pura intensidad dramática, y luego esa misma interpretación la “trasplantas” a un personaje que no se parece en nada a él… tal vez un robot de acero pulido, un alienígena con tres párpados o incluso un dibujo animado con proporciones exageradas. Eso, dicho de forma sencilla, es la famosa transferencia de animación facial.

Esta técnica, llamada en inglés animation transfer, consiste en capturar los gestos y microexpresiones de una persona y aplicarlos a un modelo 3D completamente diferente.

Aunque el personaje no tenga nada que ver con el actor —ni la forma de la cara, ni la textura de la piel, ni siquiera los ojos en el mismo sitio—, la esencia de la emoción sigue ahí. Es curioso ver cómo pasa.

Con herramientas como FreeAvatar o Face2Face el proceso es casi como tener un intérprete en un idioma muy raro: toman los gestos del actor, los “traducen” y se los ponen al modelo 3D que toque. Si el actor frunce el ceño con rabia o sonríe de forma tímida, el personaje hará lo mismo… aunque tenga tres antenas, una boca metálica o una mandíbula que parece sacada de un robot de los ochenta.

En los videojuegos, esto abre un abanico enorme de posibilidades. Piensa en un RPG multijugador en el que tu avatar gesticule exactamente como tú, en tiempo real, solo usando la cámara de tu portátil.

O en un creador de contenido que aparezca en sus transmisiones como un personaje animado y expresivo, interactuando con el público sin mostrar jamás su rostro real.

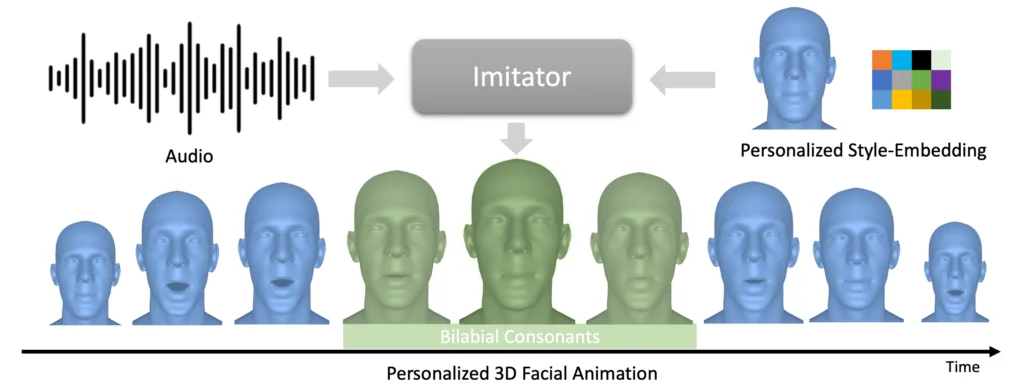

Animación facial impulsada por audio

Una de las tareas más delicadas en animación es sincronizar labios y voz. Si alguna vez has visto un doblaje mal hecho, sabes lo incómodo que puede ser cuando el movimiento de los labios no coincide con lo que se escucha.

Durante décadas, esto se resolvía manualmente: animadores que, fotograma a fotograma, ajustaban la boca del personaje para que coincidiera con cada sílaba.

Con la animación facial impulsada por audio (audio-driven facial animation), este trabajo tedioso se reduce drásticamente. El sistema escucha la grabación y predice no solo el movimiento de los labios, sino también la posición de la lengua, la apertura de la mandíbula y las microexpresiones asociadas.

La cosa tiene más pasos de los que uno pensaría. Primero, el audio se rompe en pedacitos muy pequeños, llamados fonemas, que son como las sílabas mínimas del habla. Después, una red neuronal los traduce en visemas, que son las posiciones que pone la cara para sonar así.

Pero no es solo mover la boca: también “escucha” la emoción. Si la voz suena alegre, mete una sonrisita apenas visible; si suena tensa, aprieta un poco la mandíbula o frunce el entrecejo.

En el cine, eso ha hecho que algunos doblajes sean casi imposibles de distinguir del original: el personaje parece hablar el nuevo idioma de verdad. Y fuera del cine, en educación, ya hay tutores virtuales que no solo repiten palabras, sino que reaccionan al ritmo y hasta al humor del estudiante.

Captura emocional y micro expresiones

Sin duda, sincronizar labios es importante, pero si queremos que un personaje digital parezca realmente vivo, hay que prestar atención a los detalles más sutiles. Las microexpresiones —esas contracciones musculares involuntarias que duran menos de medio segundo— son clave para transmitir emociones genuinas.

Piensa en el momento en que alguien dice “estoy bien” pero levanta levemente una ceja o aprieta los labios: el cuerpo está comunicando algo que las palabras no dicen. Entender y transmitir esas señales emocionales sigue siendo uno de los desafíos grandes en animación facial.

Hay herramientas como EMOCA que no se conforman con copiar la forma de la cara: también intentan leer qué está sintiendo la persona. Eso hace que un avatar no solo parezca actuar, sino que dé la impresión de estar vivo.

Y en realidad virtual, donde hablas cara a cara con un personaje, ese detalle marca la diferencia… y puede ser la línea entre que el avatar te parezca simpático o que te dé un poco de escalofrío.

Animación facial sin rig en entornos RGB-D

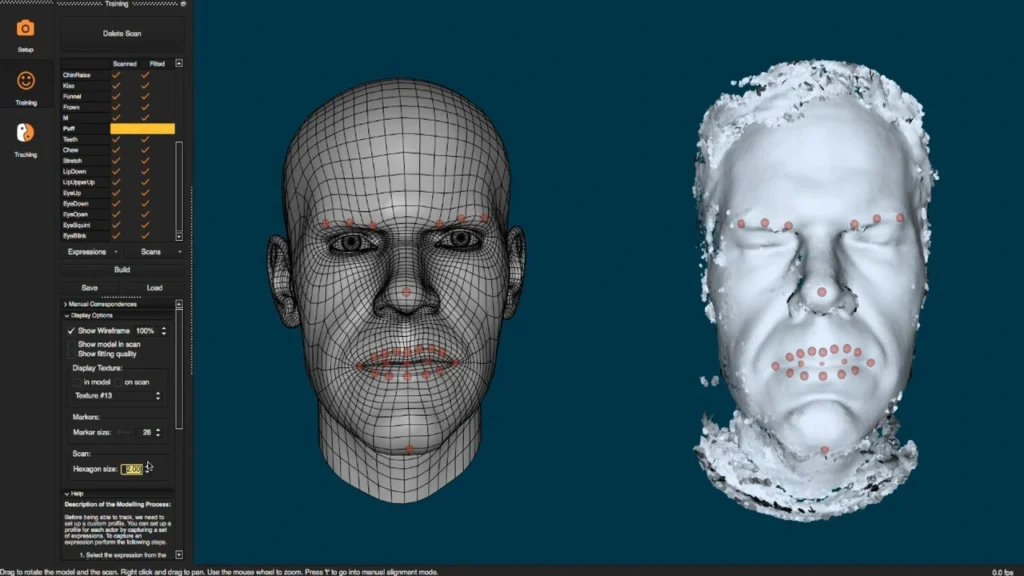

Ahora, sobre el “rig”: en animación tradicional, es básicamente un esqueleto invisible que sirve para mover el modelo 3D. Preparar uno facial no es cosa rápida; a veces son semanas de trabajo afinando cada control para que los gestos se parezcan lo más posible a los de una persona real.

Con las cámaras RGB-D (que capturan color y profundidad al mismo tiempo) y modelos de inteligencia artificial, es posible animar un rostro directamente, sin rig intermedio. Esto acelera la producción y permite trabajar con personajes muy complejos que, en otro tiempo, habrían sido imposibles de manejar en tiempo real.

El uso de esta técnica es prometedor para aplicaciones como videollamadas con avatares realistas, producciones independientes e incluso telepresencia en eventos virtuales.

Reflexión final

Todas estas técnicas tienen algo en común: acercan herramientas antes reservadas a grandes estudios a manos de creadores independientes, profesores, streamers y hasta aficionados curiosos.

El salto no es solo tecnológico, sino cultural. Estamos pasando de un mundo donde la animación facial realista era una rareza, a otro donde cualquiera con una cámara y un ordenador puede crear personajes digitales que transmitan emoción.

El desafío que viene ahora no es técnico, sino creativo: ¿cómo vamos a aprovechar esta nueva libertad?

Créditos

Autor: Juan Felipe Ramirez Sánchez

Editor: Mg. Carlos Iván Pinzón Romero

Código: CG-20252

Universidad: Universidad Central

Fuentes:

Daněček, R., Black, M. J., & Bolkart, T. (2022). EMOCA: Emotion-driven monocular face capture and animation. arXiv preprint arXiv:2204.11312. https://arxiv.org/abs/2204.11312

Jiang, D., Chang, J., You, L., Bian, S., Kosk, R., & Maguire, G. (2024). Digital human expression animation and evaluation: A review. Information, 15(11), 675. https://doi.org/10.3390/info15110675

Liu, C., Lin, Q., Zeng, Z., & Pan, Y. (2024). EmoFace: Audio-driven Emotional 3D Face Animation. arXiv preprint arXiv:2407.12501. https://arxiv.org/abs/2407.12501

Wikipedia contributors. (2025, agosto 15). Facial action coding system. En Wikipedia. https://en.wikipedia.org/wiki/Facial_Action_Coding_System

Liu, Q., Kim, H., & Bharaj, G. (2024). Content and style aware audio-driven facial animation. arXiv preprint arXiv:2408.07005. https://arxiv.org/abs/2408.07005

Imágenes

Imagen destacada:

fxguide.com. (2015, agosto 4). Performance driven facial animation [Imagen]. en fxguide. https://www.fxguide.com/fxfeatured/performance-driven-facial-animation/

Imagen 1:

Wiley. (2024). Expresiones faciales en rejilla [Imagen]. https://onlinelibrary.wiley.com/doi/10.1111/cgf.15263

Imagen 2:

VFX Voice. (2024). Animación facial con malla y puntos de seguimiento [Imagen]. https://www.vfxvoice.com/realistic-facial-animation-the-latest-tools-techniques-and-challenges/

Imagen 3:

Wiley. (2024). Rostros estilizados con expresiones múltiples [Imagen]. https://onlinelibrary.wiley.com/doi/10.1111/cgf.15263

Imagen 4:

Thambiraja, B. et al. (2023). Diagrama de animación facial driven por audio [Imagen]. https://balamuruganthambiraja.github.io/Imitator/

Video

Invideo AI. (2025, fecha de visualización). ¡Así se anima el futuro! 5 técnicas que están cambiando la animación facial [Video]. InVideo. https://ai.invideo.io/watch/YL6zY-v62DO