Teoría de la información de Shannon

Introducción

La teoría de la información de Shannon, es un planteamiento que se dedicó a estudiar la medición y procesamiento de datos durante la transmisión de una información. Básicamente esta teoría plantea el flujo de un mensaje entre el emisor y el receptor por medio de un canal predeterminado, logrando representar la información transmitida, así como la capacidad de procesamiento de los sistemas de comunicación para transmitir dicha información.

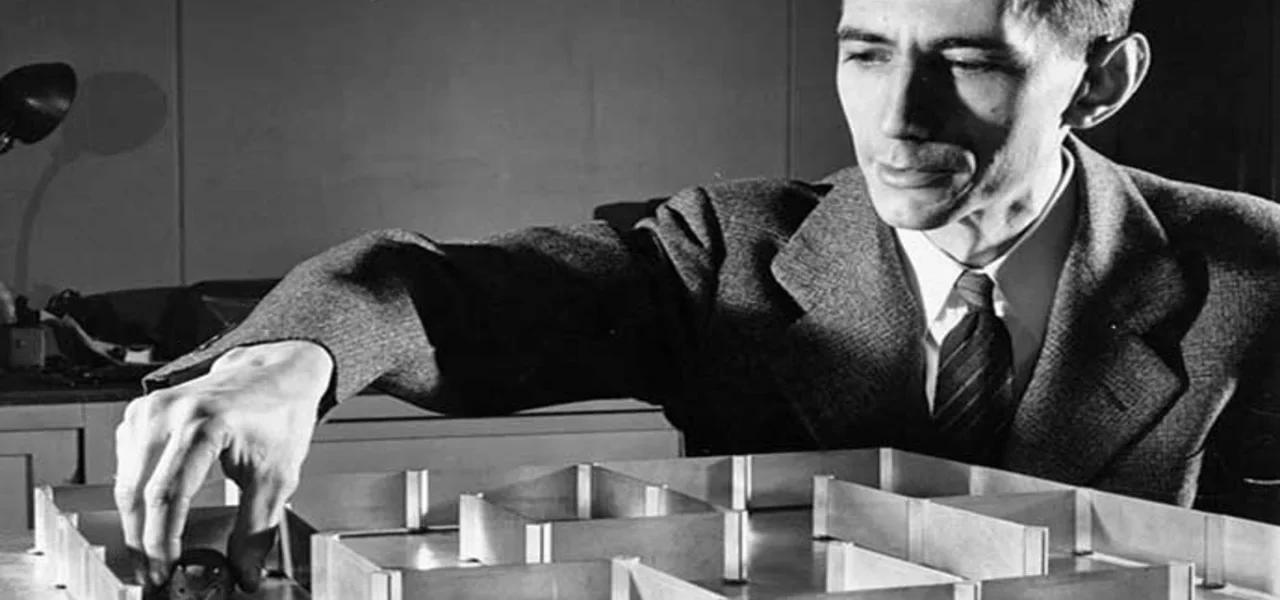

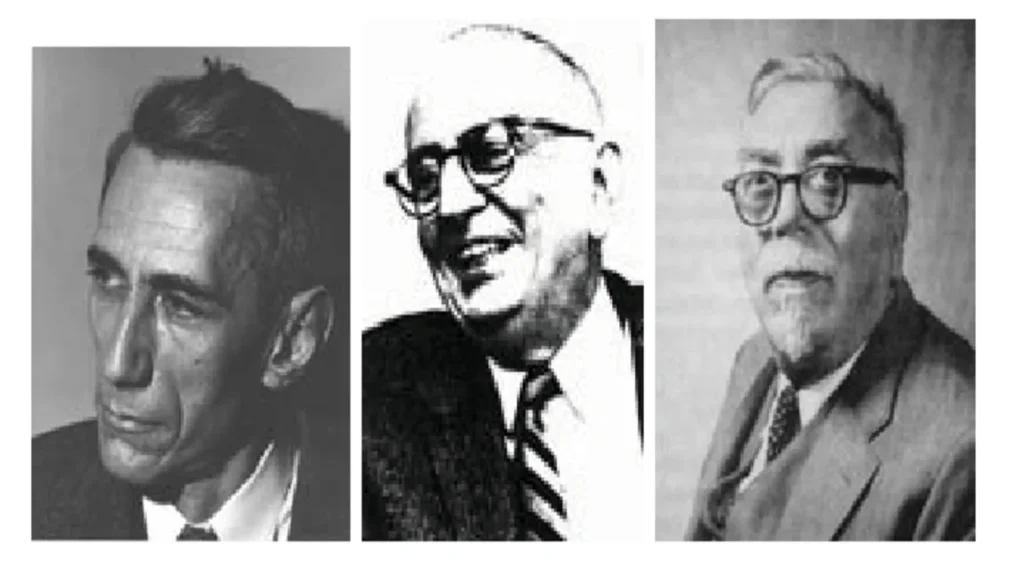

Claude Shannon

Claude Elwood Shannon fue un matemático, ingeniero eléctrico y criptógrafo estadounidense el cual nació en el año 1916 en Michigan y murió en el año 2001, es recordado como el padre de la teoría de la información, pues fue quien fundó este campo con la teoría matemática de la comunicación con la publicación de un artículo en el año 1948. A su vez también realizó importantes contribuciones a la teoría de los circuitos eléctricos, la criptografía y la computación.

Gracias a su trabajo introdujo conceptos fundamentales como la entropía de la información, la redundancia y la capacidad de canal. Estos conceptos revolucionaron los campos de la comunicación y la computación, sentando las bases para el desarrollo de la informática y las telecomunicaciones modernas. Por otro lado también desarrolló el concepto de “máquina de Turing”, una idea precursora de la computación digital moderna, generando un impacto duradero hasta el día de hoy.

Adicionalmente Claude Shannon, conocido como el “padre de la teoría de la información”, no solo revolucionó las comunicaciones, sino también el mundo del ajedrez. Diseñó la primera computadora mecánica para jugar ajedrez en 1949, llamada “The Machine”. Además, creó un dispositivo que podía mantener una peonza en equilibrio sobre su punto más estrecho, demostrando su ingenio más allá de las matemáticas y la ingeniería.

Origen de la teoría de la información de Shannon

Durante la Segunda Guerra Mundial, trabaja en los laboratorios Bell en cuestiones relacionadas con la criptografía, siendo esta una experiencia que le permite construir las bases para su futura investigación en el campo de la información, pues su ideal era abordar el problema fundamental de cómo transmitir información de manera eficiente y sin errores a través de un canal de comunicación, como un cable telefónico o una radio.

La teoría de la información de Shannon comienza definiendo la comunicación desde términos matemáticos dividiendo el contenido de la información de su forma física, para poder observar la comunicación desde una postura más técnica. Durante este proceso introdujo términos como la entropía de la información el cual hace referencia a el grado de desorden de un sistema causado por el ruido, es decir medida promedio de la información contenida en un mensaje, otro de los términos es el Bit la cual es la unidad básica de la información, tenemos la codificación que es el proceso de asignar códigos a datos para poder expresarlos de manera eficaz, la redundancia que es la información que se repite en un mensaje se utiliza para la corrección de errores, por último tenemos el canal de comunicación el cual es el medio por el cual la información es transmitida del emisor al receptor.

Elementos de la teoría de la información de Shannon

Shannon dentro de su teoría define los elementos claves para llevar a cabo el proceso de comunicación, en primera instancia nos encontramos con la fuente que es aquella que emite el mensaje, es decir una fuente puede ser una computadora ya que es un dispositivo de transmisión, dentro de la teoría de la información existen varios tipos de fuentes, tenemos las aleatorias y las estructurales la primera hace referencia a cuando es imposible predecir cual será el próximo mensaje.

Otro de los elementos de esta teoría es el mensaje el cual es una representación binaria, es como un archivo que viaja por medio de una red, el otro elemento es el código el cual de igual forma es un conjunto de ceros y unos que se utilizan para representar el mensaje, por último tenemos el emisor y el receptor.

Antecedentes de la Teoría de la información de Shannon

Antes de las propuestas de Claude Shannon existieron autores que marcaron la base para la creación de esta teoría, pues las contribuciones de estos autores proporcionaron los fundamentos matemáticos y conceptuales necesarios, por un lado en la década de 1910 Andréi Markovi habla sobre procesos estocásticos los cuales son las variables sometidas a procesos aleatorios, en 1928 Ralph Hartley plantea que la información se podía medir o calcular con el logaritmo del número de símbolos que se transmiten; años mas adelante Warren Weaver influye en la investigación de Shannon proponiendo la idea de aplicar métodos cuantitativos al estudio de la comunicación por medio de su artículo”Recent Contributions to the Mathematical Theory of Communication”, otro autor que influyó en la teoría es Noam Chomsky quien aplicó por primera vez en el ámbito de la lingüística con la publicación de “Syntactic Structures”, donde se utiliza la teoría para abordar la gramática generativa.

Influencias posteriores

Por último encontramos autores como Alan Turing y Kurt Gödel que influyeron con su trabajo de matemáticos proporcionando fundamentos para la formalización de conceptos en la teoría de la información de igual manera exponen cómo se descifró códigos nazis durante la época de la segunda guerra mundial, John Von Neumann aportó a la guerra fría en la comisión de energía atómica, Norbert Wiener quien fue el que fundó la cibernética, Andréi Kolmogórov, influyó al proporcionar un marco matemático para medir la incertidumbre y la probabilidad de eventos, Rudolf Clausius contribuyó en la teoría aportando conceptos de la termodinámica, como la entropía, el cual Claude Shannon utilizó para describir la incertidumbre y la cantidad de información en un sistema. y por último Robert Gallager que fue el que ayudó a difundir y popularizar los conceptos de la teoría de la información de Shannon por medio de la publicación de su libro.

Estas influencias demuestran cómo la teoría de la información ha emergido como una disciplina interdisciplinaria que aborda problemas fundamentales en diversas áreas. Claude Shannon, con su trabajo pionero, unificó y formalizó estos conceptos en la teoría de la información moderna en su artículo de 1948, sentando las bases para su aplicación en una amplia gama de campos.

Teoría general de los sistemas

Desde la perspectiva de Bertalanffy si miramos a nuestro alrededor siempre nos encontramos rodeados de diferentes tipos de organismos los cuales cada uno interactúa de manera diferente dependiendo de sus objetivos y necesidades, este autor decide llamar dicho fenómeno como sistemas; definiendo a un sistema como aquel que está compuesto por sus propios elementos los cuales se relacionan e interactúan entre sí intentando mantener un equilibrio para lograr un objetivo en común. Desde su teoría la cual se titula teoría general de los sistemas, propone que estos sistemas se componen de una estructura y organización, de esta manera permitiendo que todos los elementos del sistema se interrelacionan entre sí.

Teoría de la información de Shannon y TGS

Tomando en cuenta la descripción anteriormente expuesta, y los postulados propuestos por Shannon dentro de su teoría de la información, podemos llegar a decir que la comunicación es también un sistema, uno que está compuesto por los elementos de emisor, receptor, mensaje, y canal; donde es imprescindible que todos sus elementos estén en perfecto equilibrio y conexión, pues es la manera de poder llegar a una comunicación efectiva, ya que es de gran importancia que existan procesos de comunicación eficaces dado que la comunicación es un sistema que comprende muchos subsistemas en la sociedad.

Influencia de la teoría en la actualidad

La teoría de la información, en la actualidad, emerge como un pilar muy importante para el sostenimiento de los cimientos de nuestra sociedad moderna, su importancia se enfoca en un catalogo amplio de diferentes disciplinas, desde las comunicaciones y la informática hasta la biología y la inteligencia artificial. Este cuerpo conceptual, cuyo linaje se remonta a las contribuciones de Claude Shannon en 1948, ha trascendido las barreras disciplinarias, estableciéndose como una herramienta esencial para comprender, cuantificar y optimizar la transmisión de datos en un mundo cada vez más interconectado.

influencia en las diferentes áreas

En el ámbito de las comunicaciones, la teoría de la información se manifiesta como la brújula que guía el diseño y funcionamiento de los sistemas de transmisión de datos. Desde la telefonía móvil hasta el internet, la capacidad de transmitir información de manera eficiente y precisa es fundamental.

La teoría de la información proporciona las herramientas para medir la capacidad de los canales de comunicación, entender cómo la redundancia puede ser aprovechada para la corrección de errores, y diseñar algoritmos de compresión que permiten la rápida transferencia de datos sin pérdida significativa de información.

Influencia área informática

En el ámbito informático, la teoría de la información impulsa avances significativos en la compresión de datos y la gestión eficiente de la información. Los algoritmos desarrollados en este marco teórico han revolucionado la forma en que almacenamos y compartimos datos. Desde los primeros días de la computación, donde cada bit era precioso, hasta la era actual de grandes volúmenes de información, la teoría de la información ha abarcado el camino para soluciones innovadoras en la manipulación de datos y la toma de decisiones basada en información.

No menos importante es la influencia de la teoría de la información en el ámbito de la inteligencia artificial y el aprendizaje automático. La medición de la información y la entropía son herramientas cruciales para evaluar la eficacia de los modelos de aprendizaje automático. La teoría de la información cuántica, una extensión intrigante de los principios fundamentales de la teoría de la información, ha desencadenado nuevas posibilidades en la computación cuántica, donde la información se manipula de manera radicalmente diferente gracias a los qubits y la superposición cuántica.

Influencia área de la biología

En el campo de la biología molecular, la teoría de la información ha encontrado aplicaciones fascinantes. Los procesos biológicos, desde la replicación del ADN hasta la transcripción y traducción, pueden ser interpretados bajo la teoría de la información.

La codificación y decodificación de la información genética, el flujo de datos en la maquinaria molecular de las células, se alinea con los conceptos fundamentales de la teoría de la información, proporcionando una perspectiva unificada para entender cómo la vida misma se comunica y perpetúa.

Influencia área seguridad

Asimismo, la teoría de la información de Shannon ha transformado nuestra percepción de la seguridad y la criptografía, los protocolos de cifrado, los algoritmos de seguridad y las técnicas de protección de la información se apoyan en los principios fundamentales de la teoría de la información para proteger la privacidad y la integridad de los datos en un mundo donde la ciberseguridad se ha vuelto crítica.

Conclusiones

En conclusión, la teoría de la información no solo prima como un principio rector en el ámbito de las comunicaciones, sino que también permea y enriquece diversos aspectos de nuestra sociedad moderna. Su influencia se extiende desde la transmisión de datos hasta la toma de decisiones en la inteligencia artificial, desde la replicación del ADN hasta la seguridad de la información en el mundo digital, también es muy utilizada en aspectos generales de la vida de las personas como pagos, transacciones electrónicas, procesos de autentificación, En un mundo donde la información es el oro del siglo XXI, la teoría de la información sigue siendo un tesoro intelectual invaluable que impulsa la innovación y moldea la forma en que entendemos y navegamos el inmenso océano de datos que nos rodea.

Autor : Wilson Rosendo Martin Jiménez

Editor : Carlos Ivan Pinzón Romero

Código : UCPS-10

Universidad : Universidad Central

Referencias:

Lemnismath. (2 nov 2022). La paradoja de la información y la teoría de Shannon [Video]. YouTube. https://youtu.be/4ic-J79O9hg?si=us-eMF8JzhKgw5ds

Seising, R. (2009) C. E. Shannon, W. Weaver and N. Wiener. [Imagen]. ResearchGate. C. E. Shannon, W. Weaver and N. Wiener. | Download Scientific Diagram (researchgate.net)

La voz redacion (2016) Claude Shannon: El padre del «bit» y la teoría de la información. [Imagen]. La voz de Galicia. Claude Shannon: El padre del «bit» y la teoría de la información (lavozdegalicia.es)

Teoría de la información: qué es, cómo surge, elementos y aplicaciones. (2023, 10 enero). Ferrovial. https://www.ferrovial.com/es/stem/teoria-de-la-informacion/

Teoría de la información – Numerentur.org. (s. f.). https://numerentur.org/teoria-de-la-informacion/

Ralph Hartley – uno de los fundadores de la teoría de la información. (s. f.). Distribuidor de Componentes Electrónicos. Tienda En Línea: Transfer Multisort Elektronik. https://www.tme.com/us/es/news/library-articles/page/44786/ralph-hartley-uno-de-los-fundadores-de-la-teoria-de-la-informacion/

Baecker, D. (2017). Teorías sistémicas de la comunicación. Revista Mad. Revista del Magíster en Análisis Sistémico Aplicado a la Sociedad, (37), 1-20.

Bedoya, A. M. (2016). Teoría de la Información más que una teoría matemática. Revista e-ikon, 3(1), 29-32.

Villa, M. C. (2008). Fundamentos de la teoría de la información. ITM

Blasco, R. (2022) Cuáles son los elementos de la comunicación.[Imagen]. unprofesor. Descubre TODOS los ELEMENTOS de la COMUNICACIÓN – ¡RESUMEN y EJEMPLOS! (unprofesor.com)