De la VGA a la RTX: La Historia y el Futuro de las Tarjetas Gráficas

Las tarjetas gráficas son un componente de una computadora puede estar integrada el mismo procesador o ser una unidad externa, su función principal es la renderización de imágenes, es decir todo lo que vemos en pantalla desde el inicio de Windows hasta un video juego, se están procesando y ejecutando datos gráficos mediante diferentes técnicas, características y funciones dependiendo su modelo y tipo de tecnología que utiliza.

Existen dos tipos de tarjetas gráficas, las integradas que forman parte del mismo procesador, y las dedicadas que se conectan a parte en la placa base como si fueran una unidad externa.

En general cuando está integrada la gráfica en el mismo procesador suelen ser menos potentes que las tarjetas gráficas externas, por lo tanto, si se requiere de trabajo de edición, video juegos o en la actualidad trabajo de inteligencia artificial se requieren de tarjetas gráficas externas lo más potentes posibles.

¿Cómo funciona una tarjeta gráfica?

El componente principal de una tarjeta gráfica es la GPU o también llamada Unidad de procesamiento gráfico, es un circuito muy complejo que tiene integrado millones de transistores muy pequeños y se tienen núcleos que tienen una frecuencia de reloj en MHz. Estos núcleos procesan datos para generar imágenes aplicando diferentes efectos y texturas, cuenta con la VRAM, es la memoria de la gráfica en sí, esta tiene un ancho de banda tiene una cantidad y tipo de memoria en específico, de todos estos componentes depende el rendimiento final de la tarjeta gráfica.

Otro componente importante es el convertidor digital – analógico de memoria de acceso aleatorio que también tiene como nombre RAMDAC. Este es un conversor de señal digital a señal analógica que tiene como función recoger todas las señales digitales que nos da la tarjeta gráfica y las convierte a un tipo de señal que puede traducir el monitor al que esté conectado el computador y poder visualizar el contenido. Dependiendo la capacidad del convertidor digital analógico de memoria de acceso aleatorio se puede convertir la señal para adaptarla a diferentes velocidades de refresco del monitor.

Las tarjetas gráficas incluyen su propio sistema de ventilación como ventiladores integrados, el número de estos depende la gama de la gráfica, se tienen ventiladores debido a que se enfrentan a tareas muy exigentes concentradas en un pequeño espacio por lo que estos ventiladores ayudan a la expulsión del calor del chip y en general toda la gráfica.

¿Como se generarán los gráficos?

En la generación de gráficos, el proceso que pasa en nuestro computador es el siguiente, primero la CPU se encarga del procesamiento de vértices, después de obtenida esta información la procesa en su ordenamiento espacial y que partes de estas serán mostradas gráficamente, seguidamente pasamos con el procesamiento de pixeles que es finalmente lo que vamos a ver en nuestro monitor, aquí es donde entra la a trabajar la tarjeta gráfica y la parte más pesada, donde se aplica todos los efectos para poder crear las texturas, las capas de gráficos.

Cuando se realizan todas estas operaciones la tarjeta gráfica envía la información al monitor, para que esta información pase de tarjeta gráfica a pc se tienen diferentes puertos de salidas como VGA, HDMI,DVI o DISPLAYPORT.

Principales fabricantes de tarjetas graficas

Actualmente, existen tres empresas de desarrollo de tarjetas gráficas que son AMD, Nvidia e Intel dominan el mercado actual con sus diferentes tecnologías. Aunque esta última Intel se está incorporando poco a poco en este mundo con su modelo Arc en el 2022.

Por otro lado, existen fabricantes como Asus,MSI,Gigabyte los cuales utilizan fabrican tarjetas gráficas basadas en las arquitecturas de las desarrolladas Nvidia o AMD, estos fabricantes tienen sus modelos, pero simplemente es estético, añadiendo diseños de refrigeración personalizados y mejores en el rendimiento de la tarjeta grafica

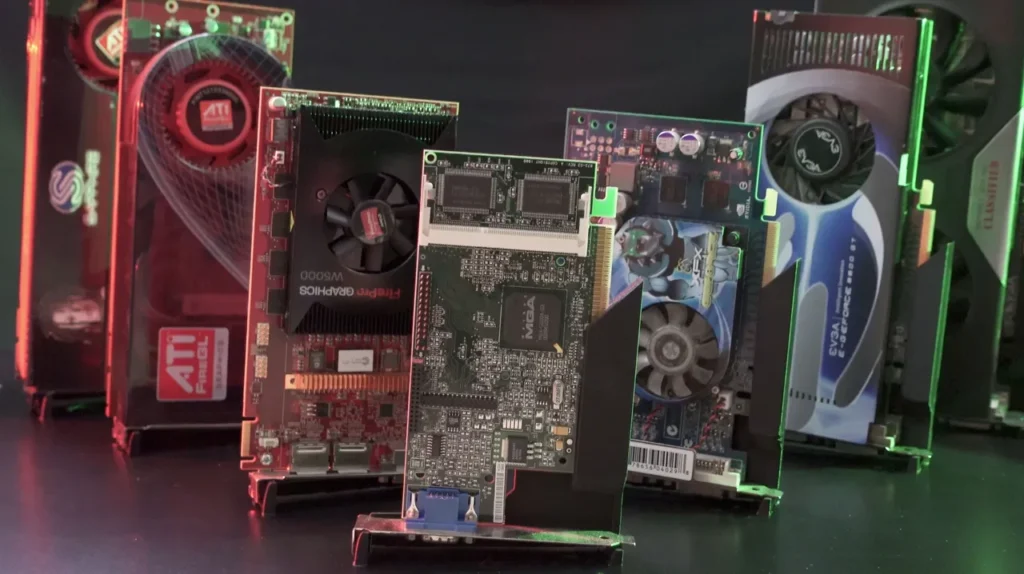

Historia de las Tarjetas Graficas

La primera tarjeta gráfica que fue desarrollada fue por la empresa reconocida IBM en el año 1981, esta primera tarjeta se llama Monochrome Display Adapter para IBM PC, esta tarjeta funcionaba en texto y podría representar 25 líneas de 80 caracteres en pantalla, esta tarjeta gráfica contaba con memoria RAM de vídeo de 4kb por lo tanto solo podía usar una página de memoria. Esta tarjeta gráfica se usaba con monitores monocromáticos los que utilizaban cañón de electrones y su imagen tenía tonalidades verdes.

Ese mismo año llegaron los primeros colores y gráficos, gracias a esta nueva tecnología CGA se podía desarrollar tanto en texto como gráficamente. En el modo texto lograba representar lo mismo que el MDA (Monochrome Display Adapter) la desventaja era que el texto era menos entendible por que los caracteres eran muy pequeños debido a la matriz.

En 1982 se desarrolló la tarjeta gráfica HGC o Hercules graphics Card por Van Suwannukul, en esta generación se podía trabajar con dos páginas con resolución 720 x 348pixeles, pero como desventaja se tenía que no era capaz de mostrar colores por pantalla. Posteriormente en el 1985 IBM presento EGA, esta tarjeta era compatible con MDA y CGA tiene una resolución de 640×350 pixeles la cual podría representar 16 colores de una paleta de 64 y por último un aumento de RAM de video hasta 256 kb

El primer estándar como tarjeta grafica

En 1990 IBM creó la VGA, el cual fue muy bien recibida por el mercado en ese tiempo, fue tan buena que otras empresas como Cirrus, Logic y ATI trabajaron sobre esta tarjeta gráfica mejorando su resolución y cantidad de colores. Con este desarrollo nació la tarjeta gráfica SVGA, llegando a los 2 MB de memoria de video y alcanzó una resolución de 1024×768 pixeles llegando a 258 colores, esta tarjeta puso un antes y después en este mundo.

En 1995 hubo otro punto de inflexión con la aparición de las primeras tarjetas 2D/3D la cuales fueron fabricadas por las empresas ATI, Matrox y Creative,estableciendo un estándar para los efectos 3D estas tarjetas gráficas tenían tecnología SVGA, pero con las funciones 3D. En 1997, Nvidia lanzó un chip gráfico con gran potencia de cálculo, efectos 3D a partir de esto se crean gráficas como Voodoo2, TNT y TNT2 de Nvidia.

Nvidia y la revolución de las GPU

En el 1999 la empresa NVIDIA se apoderó del mercado de las tarjetas gráficas con su modelo GeForce.En este mismo año crean el procesador dedicado de las tareas gráficas llamado GPU que viene interna en la tarjeta de video, esto fue un gran paso ya que la primera GPU fue llamada GeForce 256 podia procesar más de 10 millones de polígonos por segundo.

Según los años iban pasando se centraron en mejorar los distintos algoritmos 3D y la velocidad de los procesadores gráficos. Al mismo tiempo las memorias tenían que dar un salto y debido esto se introdujeron las memorias DDR a las tarjetas gráficas.

En el 2004 Nvidia lanza una tecnología llamada SLI que permite combinar la potencia de dos o más GPU en la misma computadora. En 2006, AMD adquirió ATI por más de 5.400 millones de dolares,convirtiendose en el principal competidor de Nvidia

Evolución y Futuro de las Tarjetas Gráficas

AMD lanza la ATI Radeon HD 5970 la cual fue considerada la gráfica más rápida del mundo en el 2009 .Nvidia en el 2012 sacó una GPU con tecnología GRID que traslada el procesamiento gráfico a la nube.

A medida que pasaban los años las tarjetas gráficas pasaron a ser de un solo núcleo a tener diferentes núcleos programables. En los últimos años han habido avances grandes en las tarjetas gráficas como la generación RTX 2000 de Nvidia que introdujo núcleos Tensor que son especiales en cálculos de IA.

Esto permitió el desarrollo de la tecnología DLSS el cual servía para la mejora del rendimiento en los videojuegos, la serie RTX 3000 de Nvidia siguió con las mejoras llevando la potencia de los núcleos Tensor, la serie RTX 4000 trajo avances grande en el campo de la IA debido a que se presentó el DLSS 3 que no mejoraba la resolución sino que se introdujo la generación de fotogramas por medio de la IA aumentando los FPS de manera sustancial la próxima generación, la serie RTX 5000 apunta a grandes avances en inteligencia artificial y rendimiento. El futuro de las tarjetas gráficas lleva una combinación superior en tanto eficiencia energética como a inteligencia artificial avanzada.

Conclusión

Las tarjetas gráficas han evolucionado de adaptadores de videos sencillos a poderosas unidades de procesamiento que son capaces de manipular grandes procesos de gráficos e inteligencia artificial.

Con nuevas tecnologías como el Ray Tracing o la generación de fotogramas con ayuda de la inteligencia artificial, la compañía como Nvidia se está enfocando cada vez más a la inteligencia artificial, pero de igual forma las tarjetas gráficas estarán siendo una parte importante de la computación grafica. Cada vez que siguen las generaciones de graficas se buscara un mayor rendimiento con menor consumo energético dando así un mejor equilibrio en todas las tareas que puede realizar una tarjeta gráfica como por ejemplo video juegos, diseño, cálculos e inteligencia artificial.

CREDITOS

Autor: Juan Diego Arias Montenegro

Editor: Magister e ingeniero Carlos Iván Pinzón Romero

Código: UCCG1-10

Universidad: Universidad Central

Fuentes:

Atomix. (2017, 3 de febrero). La evolución de las tarjetas gráficas a través de la historia. Atomix. https://atomix.vg/la-evolucion-de-las-tarjetas-graficas-a-traves-de-la-historia/

Tecnopedia. (s.f.). Origen de la tarjeta de video. Tecnopedia. https://tecnopedia.net/historia-tecno/origen-de-la-tarjeta-de-video/

TimeToast. (s.f.). Historia de las tarjetas de video. TimeToast. https://www.timetoast.com/timelines/historia-tarjetas-de-video

Suárez, J. (2020, 28 de diciembre). Tarjeta gráfica: qué es, qué hay dentro y cómo funciona. Xataka. https://www.xataka.com/basics/tarjeta-grafica-que-que-hay-dentro-como-funciona

PCComponentes. (s.f.). Cómo elegir una tarjeta gráfica. PCComponentes. https://www.pccomponentes.com/como-elegir-tarjeta-grafica

PC Tech Trove. (s.f.). Tarjetas gráficas. PC Tech Trove. https://pctechtrove.com/componentes-para-pc/tarjetas-graficas/

Blog El Hacker. (2024, marzo). Historia de las tarjetas gráficas: Los inicios, GPU, GeForce y Radeon. El Hacker. https://blog.elhacker.net/2024/03/historia-de-las-tarjetas-graficas-los-inicios-gpu-geforce-radeon.html

TimeToast. (s.f.). Evolución de las tarjetas gráficas. TimeToast. https://www.timetoast.com/timelines/evolucion-de-las-tarjetas-graficas

Prezi. (s.f.). La historia de las tarjetas gráficas. Prezi. https://prezi.com/p/wrdwouwdanjm/la-historia-de-las-tarjetas-graficas/

GabrieL Nerd. (2024, septiembre 5). [COMO LLEGAMOS A ESTO?] [Video]. YouTube. https://www.youtube.com/watch?v=Wyk3BTZ-VkA

TechAmb. (2023, 4 de julio). GPU storage stands V2 [Fotografía]. Printables. https://www.printables.com/model/519575-gpu-storage-stands-v2

Whitestack. (2023, 8 de noviembre). IA y la nube [Ilustración]. Whitestack. https://whitestack.com/es/blog/ia-cloud/

Bismarks. (s.f.). Mejores tarjetas gráficas para gaming [Ilustración]. Info PC Gamer. https://infopcgamer.com/mejores-tarjetas-graficas-para-gaming/

Servernet. (s.f.). Las mejores marcas de GPU [Ilustración]. Servernet. https://servernet.com.ar/mejores-marcas-de-gpu/

Ray7775. (s.f.). Video card [Ilustración]. Free Images. https://www.freeimages.com/photo/video-card-1197303